计图高斯库JGaussian开源

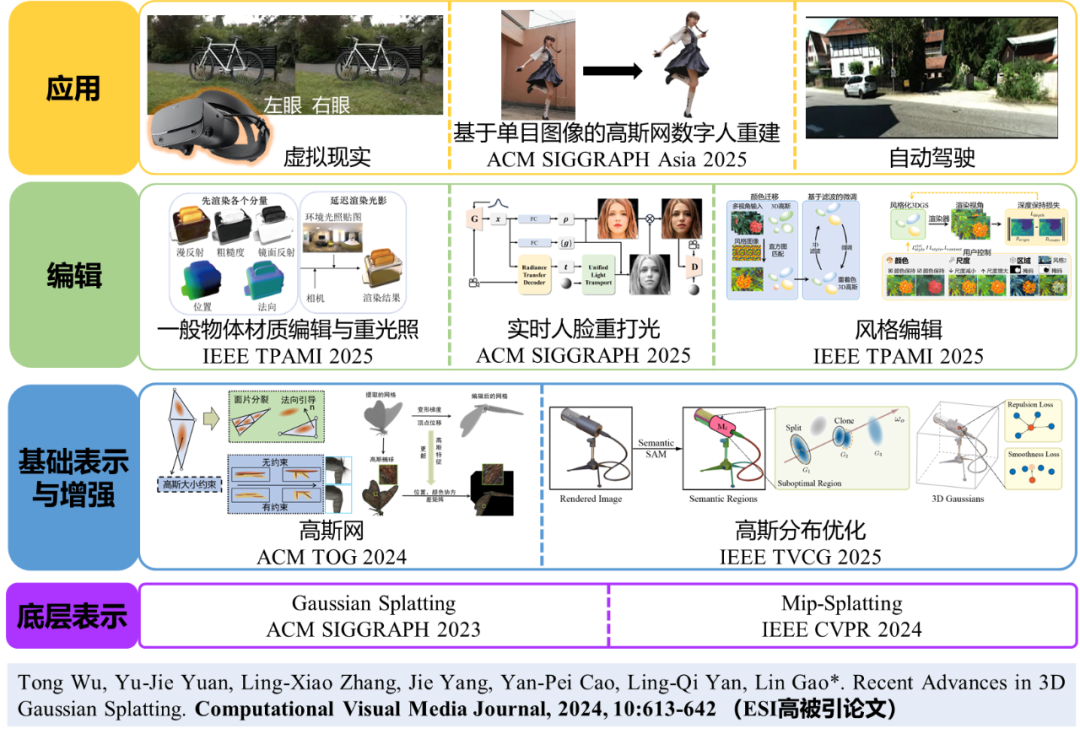

近期,中国科学院计算技术研究所的高林团队和清华大学计图团队合作,发布了计图高斯库(JGaussian),计图高斯库基于计图深度学习框架(Jittor)[1]开发,不仅拓展了高斯泼溅在几何建模、可控编辑与风格生成等方面的应用,也提供了统一的算法接口与高效的训练框架,降低了高斯泼溅方法的复用门槛。计图高斯库包含的算法与应用如图1所示,包括高斯分布优化、高斯网、一般物体材质编辑与重光照、实时人脸重打光和风格编辑五个功能,可在智能驾驶、数字人建模、虚拟现实等领域应用。《基于计图的可视媒体分析与生成方法》获得“2025年度CCF-CAD&CG优秀图形开源软件”奖,计图高斯库为该项成果的主要组成部分。

图1 计图高斯库JGaussian主要工作与应用范围

近年来,高斯泼溅(3D Gaussian Splatting) [2]作为一种高效可微三维表示方法,在三维重建、数字人建模、智能驾驶、虚拟现实等领域展现出强大潜力。相比传统体渲染与网格建模方式,高斯泼溅表示具备渲染速度快、表达能力强、硬件友好等优势,适用于多视角合成、场景建模等任务。

图2 高斯泼溅3DGS训练流程

然而,高斯泼溅在以下问题仍面临挑战:大尺度非刚性变形难以保持结构连贯性与几何一致性,缺乏稳定的几何约束机制;光照与材质属性难以解耦,在交互编辑或重光照任务中易出现伪影或模糊失真;高斯泼溅的分布缺乏优化,在遮挡区域渲染模糊失真。

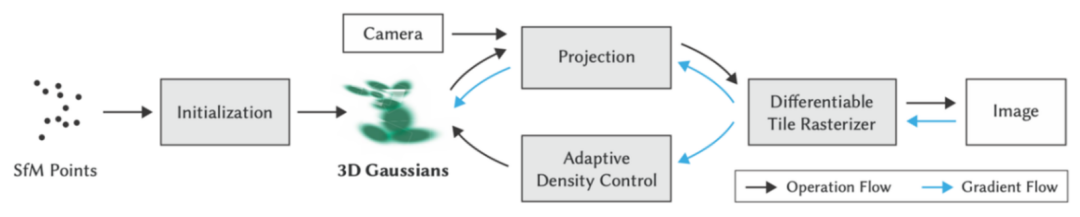

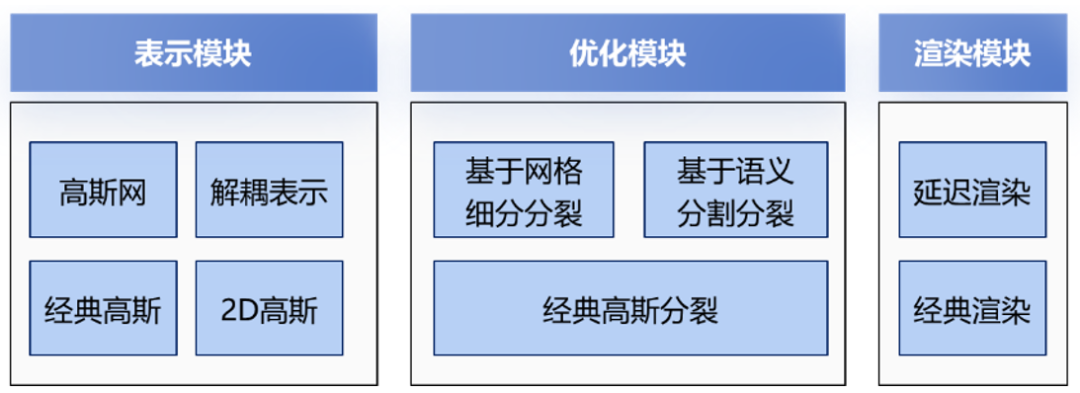

针对上述问题,研究团队在国产深度学习框架计图上整合了系列高斯泼溅表示的相关方法,开源了计图高斯库JGaussian。计图高斯库分析了高斯泼溅的训练流程,将高斯泼溅主要结构划分为图3所示的表示模块、优化模块、渲染模块3个模块,不同模块之间相互解耦,使其算法组件能够方便地调用和替换。具体而言,在表示模块,基于团队研究工作开发了高斯网表示方法和光照解耦表示方法,集成原始3D高斯表示与2D高斯表示;在渲染模块中,基于团队研究工作开发了延迟渲染方法,提供更高质量的渲染结果;在优化模块,集成了基于网格细分的分裂方法与基于语义分割的分裂方法,实现基于高斯网表示的变形,并且降低高斯点数量,增强细节渲染质量。并在此基础上,实现了高斯风格化与高斯重光照等应用。

图3 计图高斯库模块结构

计图高斯库提供多项功能,在面向高斯泼溅分布优化与大尺度变形表示方面,提供高斯分布优化以及高斯网两项功能;在高斯编辑方面提供一般物体的材质编辑与重光照,实时数字人头重打光以及风格编辑三项功能;在应用方面有单目图像重建高斯网数字人功能。具体功能介绍如下:

2.1 基于语义引导的高斯分布优化方法SeG-Gaussian

传统高斯泼溅方法依赖于累计颜色梯度进行自适应分裂和克隆操作,这使得其难以在稀疏观测区域(即输入图像中出现频率较低的区域)捕获必要的细节,从而这些区域无法积累足够的梯度来触发优化,最终导致这些不显眼的区域重建效果欠佳,影响了三维重建质量。

为了解决上述问题,研究团队提出了SeG-Gaussian[3],核心思想是利用分割信息来识别高斯泼溅表示中优化不足的区域。该方法首先利用Semantic-SAM提取图像的语义分割信息。随后,通过比较每个分割区域的平均重建误差与整张图像的平均误差,来判断该区域是否为优化不足的区域。一旦识别出目标区域,便会针对性地对其内部贡献显著的高斯点进行分裂或克隆操作,从而引导高斯点的空间分布,专注于提升稀疏区域的细节捕捉能力。

为进一步实现更紧凑、更精确的表示,该方法还引入了两个空间正则化项:斥力损失(Repulsion Loss)和平滑损失(Smoothness Loss)。斥力损失旨在最小化高斯点之间的重叠和冗余,促使它们在局部表面上均匀分布。平滑损失则通过最小化高斯点中心到其邻近点拟合的局部表面的距离,有效减少离群高斯点。这两种正则化项共同作用,在均匀分布和几何细节保留之间取得了平衡,显著改善了合成几何体的空间分布和质量。实验结果表明,在相同或更少高斯点数条件下,该方法在复杂场景中提升了新视角合成质量与几何结构保真度,相比经典高斯泼溅LPIPS提升15%。该方法被IEEE Transactions on Visualization and Computer Graphics (IEEE TVCG)录用。

图4 基于语义引导的高斯分布优化方法SeG-Gaussian

2.2 可建模大尺度几何变形的新型高斯泼溅表示方法GaussianMesh

为了解决高斯泼溅在高真实感大尺度几何变形建模中遇到的难题,研究团队提出了高斯网表示方法GuassianMesh[4],将高斯球分布定义在可灵活编辑的显式网格之上,将高斯泼溅的高效渲染能力与传统网格表示的几何约束和编辑灵活性结合在一起。这一创新不仅保证了卓越的渲染质量,更实现了高效的变形建模,在20万个高斯球的分辨率下,大尺度变形建模帧率可达每秒65帧。

高斯网核心优势在于其表征、训练优化和变形驱动三大紧密协作的模块。在表征层面,高斯网利用重建网格作为几何先验,在网格面上嵌入高斯球,引入可优化的重心坐标和法向引导策略,以保持局部连续性。在训练优化阶段,方法提出了基于面片细分策略的高斯分裂方法,并通过正则项确保高斯球形状适应变形过程。最终,在变形驱动模块,用户对代理网格进行拖拽变形后,系统能高效地将变形网格前后顶点的位移和变形梯度传递给附着的高斯球,实现高保真度的几何更新。该工作发表在ACM Transactions on Graphics (ACM TOG)上。

图5 可建模大尺度几何变形的新型高斯泼溅表示方法GaussianMesh

2.3 面向高斯泼溅的解耦与编辑方法DeferredGS

为了构建一种可解耦的高斯泼溅表示,研究团队提出了DeferredGS[5],该方法不仅保持了3DGS高质量和高效率渲染的优势,还成功解耦出精细的几何表面和准确的纹理属性,极大地增强了场景的编辑能力。

该方法的核心创新在于引入了法向场蒸馏和延迟渲染两大关键模块。为解决几何法向不准确的问题,法向场蒸馏模块巧妙地将多视角几何重建技术与高斯泼溅结合,对高斯泼溅和基于符号距离函数的神经隐式场进行联合训练,利用隐式函数提取的法向场来监督高斯球的法向属性,显著提升了几何表面的质量。不同于传统3DGS在三维空间直接渲染的模式,延迟渲染模块先利用高斯光栅器将几何与纹理属性渲染为二维分量缓冲图,再在屏幕像素空间进行光照渲染方程的计算,从而实现纹理与光照的精确解耦,有效避免了重光照时出现的瑕疵。

该方法实现了场景的高真实感重光照、几何变形和纹理编辑等多样化编辑功能,在复杂光照场景数据集上的新视图合成任务中表现出色,该工作发表在IEEE Transactions on Pattern Analysis and Machine Intelligence (IEEE TPAMI)上。

图6 面向高斯泼溅的解耦与编辑方法DeferredGS

2.4 可重光照的高效三维高斯人像生成方法GSHeadRelight

数字人像的重光照和新视角合成是虚拟现实、游戏等领域的核心需求。然而,传统的基于生成式神经辐射场(NeRF)的方法因依赖体渲染和需对每个新光照条件单独网络推理,导致渲染速度受限,难以满足实时应用的要求。因此,研究团队提出了GSHeadRelight[6],一种可重光照的高效三维高斯人像生成方法。该方法成功赋予数字人像逼真的重光照能力,同时继承了三维高斯模型(3DGS)的高效渲染优势。

GSHeadRelight的核心创新在于构建了一个基于统一神经辐射传输(PRT)的光照模型。该模型为每个高斯点配备了可学习的视角依赖球谐函数系数,以此统一建模漫反射分量和低频镜面反射分量,并模拟可见性、自遮挡等全局光照效应。模型在白光条件下训练,并通过辐射传输框架的线性特性,使在推理时能够有效泛化至任意彩色光照环境。此外,在该方法中高斯属性和辐射传输参数通过单次前向推理生成,使得重光照过程无需网络重复推理,确保了极致的渲染效率。该成果发表在ACM SIGGRAPH 2025上。

图7 可重光照的高效三维高斯人像生成方法GSHeadRelight

2.5 基于三维高斯泼溅的可控场景风格化方法StylizedGS

为了解决传统隐式神经表示风格化方法在训练时间长、灵活控制受限等方面的局限性,研究团队提出了StylizedGS[7],充分利用3DGS 高效渲染和高质量重建的优势,不仅能生成美观且高质量的风格化效果,同时还保持了卓越的几何一致性。这项技术不仅将风格化训练时间缩短至一分钟左右,还实现了任意视角的实时风格化渲染,为三维场景的艺术创作与展示提供了高效、直观的新工具。

StylizedGS的核心在于其两阶段训练框架和感知控制风格化策略。在训练的第一阶段,模型从多视角图像中重建出高精度的原始3DGS模型。训练的第二阶段是风格化优化,该过程引入了颜色匹配和伪影消除模块,确保3DGS模型和风格图像的色调一致性并去除3DGS重建中的瑕疵。为实现精细的风格迁移和结构保持,模型采用最近邻特征匹配风格损失,并引入深度保持损失来维持和原始场景的几何一致性。在此基础上,StylizedGS进一步提供了强大的用户可控性,允许用户通过定制损失项精准控制风格化的三大感知维度:颜色保持/转换(通过 YIQ 颜色空间解耦亮度)、笔触尺度(通过VGG网络层数和权重调整)以及空间区域(通过区域遮罩)。该工作发表在IEEE Transactions on Pattern Analysis and Machine Intelligence (IEEE TPAMI)上。

图8 高斯泼溅风格迁移方法StylizedGS

2.6 基于单目图像的高斯网数字人重建HumanLift

从单张参考图像重建高真实感数字人面临三维一致性不高,人脸细节模糊等问题。研究团队提出HumanLift [8]方法,用户仅需输入单张人体图片,即可重建出高质量、高逼真度的三维数字人。

图9 基于单目图像的高斯网数字人重建HumanLift

HumanLift采用两阶段方法完成任务。第一阶段是多视角图像生成,目标是从单张照片生成逼真的多视角RGB图像和法线图。该阶段设计了具备3D感知能力的HumanWan-DiT(RGB)和HumanWan-DiT(Normal)模型,它们基于视频生成模型Wan2.1并引入SMPL-X的多视角语义图像作为3D先验条件,以增强不同视角的一致性和几何细节。第二阶段是高斯泼溅模型重建,利用第一阶段生成的多视角RGB和法线图作为监督信号,对高斯泼溅参数进行优化。此外,该阶段通过对超分辨率面部图像生成高质量多视角人脸图像,并结合动态调整的SMPL-X姿态参数,确保面部相机姿态与高斯点一致,从而实现高质量的人脸细节增强。该方法发表在ACM SIGGRAPH Asia 2025上。

2.7 计图高斯库效果展示

计图高斯库通过解耦模块化设计,使用户能够调用、组合和替换其中的模块,例如用户可以使用SeG-Gaussian的分割策略训练高斯表示,同时支持StylizedGS的风格迁移和GaussianMesh大尺度变形等应用。如图10所示,乐高模型的高斯网[4]表示(左),对其变形(中)并进行风格化[7]的结果(右)。

图10 乐高模型的高斯网[4]表示(左)、变形(中)及风格化[7]的结果(右)

目前,计图高斯库已在GitHub上开源:

https://github.com/IGLICT/JGaussian

项目的主页为:

http://www.geometrylearning.com/JGaussian

计图(Jittor)是清华大学开源的自主深度学习框架,完全基于动态编译,采用元算子融合和统一计算图的新技术,并支持国产硬件。元算子易于使用,便于算子的开发和优化,而统一计算图则是融合了静态计算图和动态计算图的诸多优点,在易于使用的同时提供高性能的优化。计图官网为:

https://cg.cs.tsinghua.edu.cn/jittor/

参考文献

Shi-Min Hu, Dun Liang, Guo-Ye Yang, Guo-Wei Yang, and Wen-Yang Zhou, Jittor: a novel deep learning framework with meta-operators and unified graph execution, Science China Information Sciences, 2020, 63(12), 222103.

Bernhard Kerbl, Georgios Kopanas, Thomas Leimkühler, George Drettakis, 3D Gaussian Splatting for Real-Time Radiance Field Rendering, ACM Transactions on Graphics, 2023, 42(4), 139:1-139:14.

Ling-Xiao Zhang, Chenbo Jiang, Yu-Kun Lai, Lin Gao, SeG-Gaussian: Segmentation-Guided 3D Gaussian Optimization for Novel View Synthesis, IEEE Transactions on Visualization and Computer Graphics, doi: 10.1109/TVCG.2025.3615421.

Lin Gao, Jie Yang, Bo-Tao Zhang, Jia-Mu Sun, Yu-Jie Yuan, Hongbo Fu, Yu-Kun Lai, Real-timeLarge-scale Deformation of Gaussian Splatting, ACM Transactions onGraphics, 2024, 43(6), 200:1-200:17.

Tong Wu, Jia-Mu Sun, Yu-Kun Lai, Yuewen Ma, Leif Kobbelt, Lin Gao, DeferredGS: Decoupled and Relightable Gaussian Splatting with Deferred Shading, IEEE Transactions on Pattern Analysis and Machine Intelligence, 2024, 47(8), 6307-6319.

Henglei Lv, Bailin Deng, Jianzhu Guo, Xiaoqiang Liu, Pengfei Wan, Di Zhang, Lin Gao, GSHeadRelight: Fast Relightability for 3D Gaussian Head Synthesis, ACM SIGGRAPH 2025 conference paper, Article No. 108, 1-12.

Dingxi Zhang, Yu-Jie Yuan, Zhuoxun Chen, Fang-Lue Zhang, Zhenliang He, Shiguang Shan, Lin Gao, StylizedGS: Controllable Stylization for 3D Gaussian Splatting, IEEE Transactions on Pattern Analysis and Machine Intelligence, doi: 10.1109/TPAMI.2025.3604010.

Jie Yang, Bo-Tao Zhang, Feng-Lin Liu, Hongbo Fu, Yu-Kun Lai, Lin Gao, HumanLift: Single-Image 3D Human Reconstruction with 3D-Aware Diffusion Priors and Facial Enhancement, ACM SIGGRAPH Asia 2025.

第五届计图人工智能挑战赛决赛顺利举行,16支队伍获奖! Computational Visual Media第11卷第4期导读 基于预积分渲染的可重光照神经表面方法NeuS-PIR | CVMJ Spotlight 计图开源:基于三维高斯泼溅的可控场景风格化方法StylizedGS 基于华为昇腾的大模型推理框架JittorInfer全面升级并正式开源

可通过下方二维码,关注清华大学图形学实验室,了解图形学、深度学习、Jittor框架、CVMJ期刊和CVM会议的相关资讯。