计图开源:神经辐射场的几何编辑方法NeRF-Editing

中科院计算所、卡迪夫大学和阿里巴巴在CVPR 2022上合作发表了一项研究工作 NeRFf-Editing [1],该工作提出一种针对神经辐射场的变形算法以实现对这一隐式表征的几何编辑,并开源基于计图实现的代码。

问题和背景

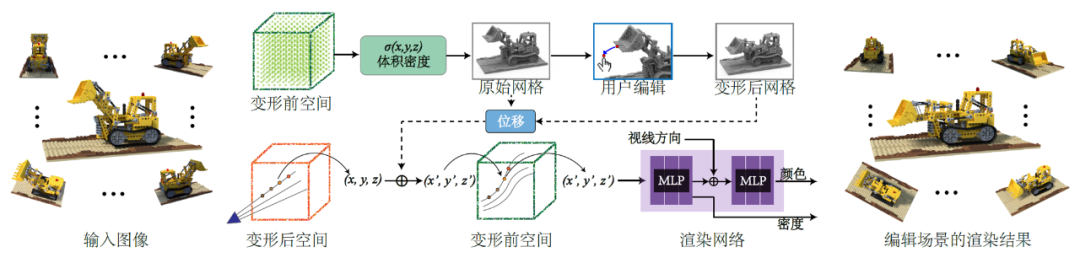

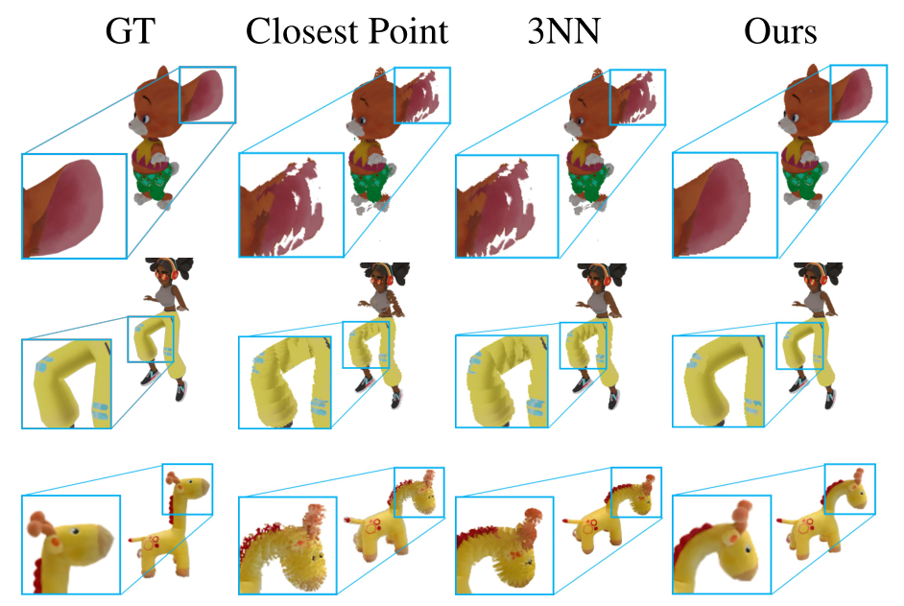

图1 编辑前后神经辐射场渲染结果

方法概述

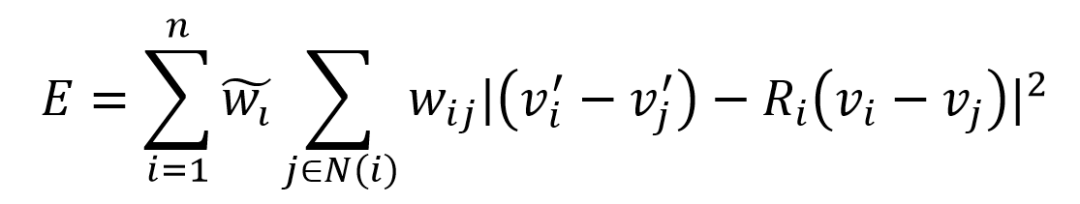

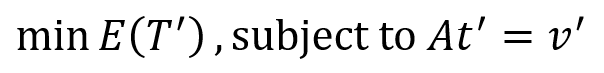

构建四面体网格(离散的体表示)来覆盖提取的三角形网格。在三角网格表面沿法线方向偏移一定距离,来得到一个包裹它的笼状网格。空间中的离散体表示可以通过对该笼状网格四面体化得到。 将面网格变形转换为空间体网格变形。利用三角形网格顶点的位移来驱动四面体网格T 的变形,得到变形后的四面体网格T'。分别记变形前后四面体网格的顶点为t 和t',该变形可通过如下的公式,优化ARAP能量式求解,其中A 是三角形网格的重心坐标权值构成的矩阵,该问题可以通过拉格朗日乘子法转化为线性方程组求解。

结果展示与Jittor开源

图5 静态神经辐射场动态化,物体变得栩栩如生

图6 对场景的编辑结果

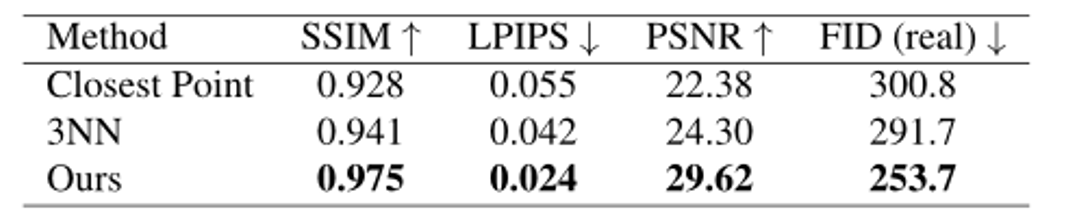

第一种是在弯曲光线时,直接选用最近邻的网格顶点位移作为该采样点的位移,记为“Closest Point”; 第二种选取了采样点最近邻的三个网格顶点,以距离的倒数作为系数线性插值得到位移,记为“3NN”。

该项目的Jittor代码已在github上开源:

参考文献

Yu-Jie Yuan#, Yang-Tian Sun#, Yu-Kun Lai, Yuewen Ma, Rongfei Jia, Lin Gao, NeRF-Editing: Geometry editing of neural radiance fields, IEEE CVPR, 2022, 18353-18364. Ben Mildenhall, Pratul P Srinivasan, Matthew Tancik, Jonathan T Barron, Ravi Ramamoorthi, and Ren Ng, NeRF: Representing scenes as neural radiance fields for view synthesis, ECCV, 2020, 405-421.

Shu-Yu Chen, Lin Gao, Yu-Kun Lai, and Shihong Xia, Rigidity controllable as-rigid-as-possible shape deformation, Graphical Models, 2017, Vol. 91, 13-21.

Lin Gao, Yu-Kun Lai, Jie Yang, Zhang Ling-Xiao, Shihong Xia, and Leif Kobbelt, Sparse data driven mesh deformation, IEEE Transactions on Visualization and Computer Graphics, 2021, Vol. 27, No. 3, 2085-2100.

Steven Liu, Xiuming Zhang, Zhoutong Zhang, Richard Zhang, Jun-Yan Zhu, and Bryan Russell, Editing conditional radiance fields, IEEE ICCV, 2021, 5773-5783.

Peng Wang, Lingjie Liu, Yuan Liu, Christian Theobalt, TakuKomura, and Wenping Wang, NeuS: Learning neural implicit surfaces by volume rendering for multi-view reconstruction, NeurIPS, 2021.

Olga Sorkine-Hornung and Marc Alexa, As-rigid-as-possible surface modeling, Symposium on Geometry Processing, 2007.

Yixin Hu, Teseo Schneider, Bolun Wang, Denis Zorin, and Daniele Panozzo, Fast tetrahedral meshing in the wild, ACM TOG, 2020, 39:117:1-117:18.

GGC往期回顾

您可通过下方二维码,关注清华大学计算机系图形学实验室,了解计算机图形学、Jittor框架、CVMJ期刊及会议的相关资讯。