计图开源:清华和中科院计算所等单位合作提出人体运动识别的Motif图卷积网络

Part1

研究背景

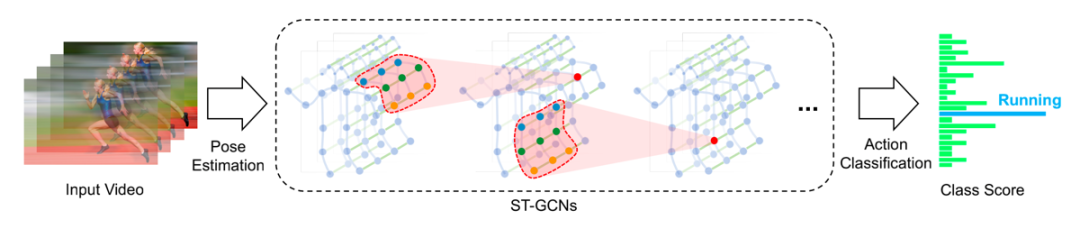

图1 基于图卷积网络的人体运动识别示意图[2]

方法简介

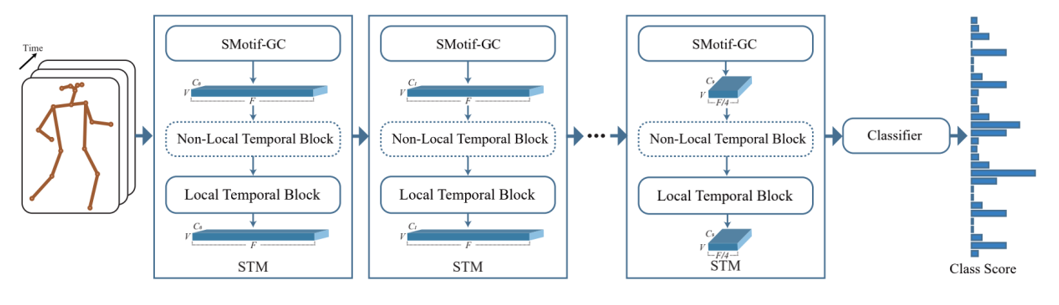

图2 网络架构图

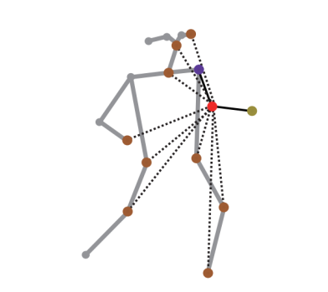

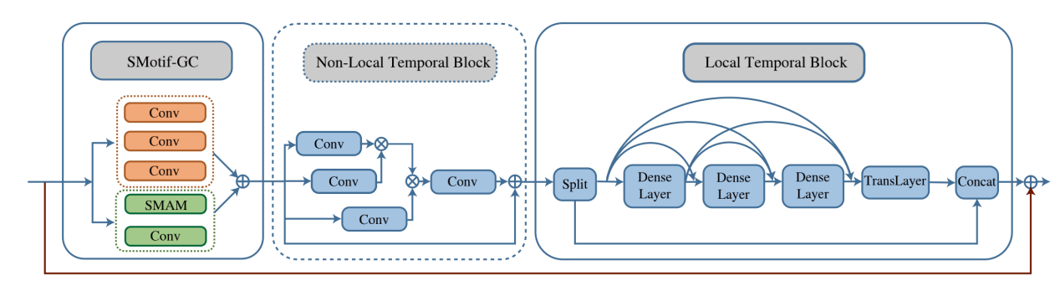

对于空间特征提取,稀疏Motif图卷积(sparse motif-based graph convolution,简称为SMotif-GC)建模骨架图(如图3所示)对各关节(以图3中红色节点关节为例)和其“邻居”关节之间建立不同的连接关系用于信息传递。论文中,“邻居”关节被定义为具有不同Motif语义角色的关节,包含关节本身(红色节点)、父关节(紫色节点)和子关节(黄绿色节点)以及非物理连接关节(橙色节点)。

图3 稀疏Motif图卷积建模骨架图

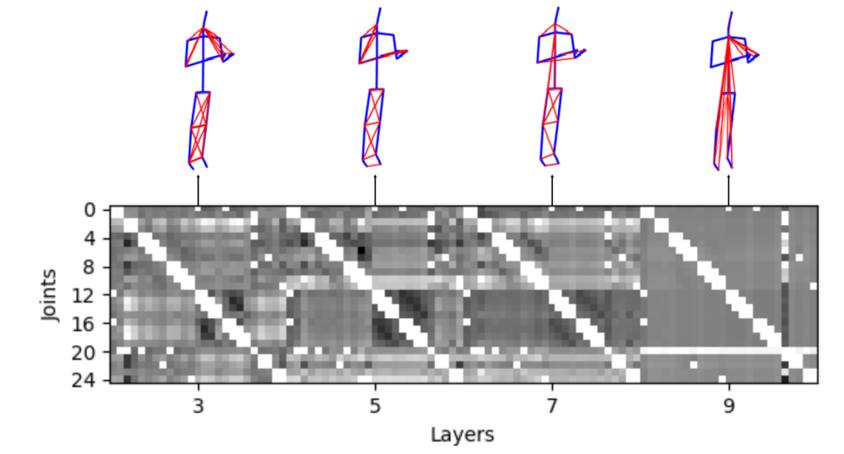

图4 稀疏邻接矩阵随着网络层之间的信息传递更新

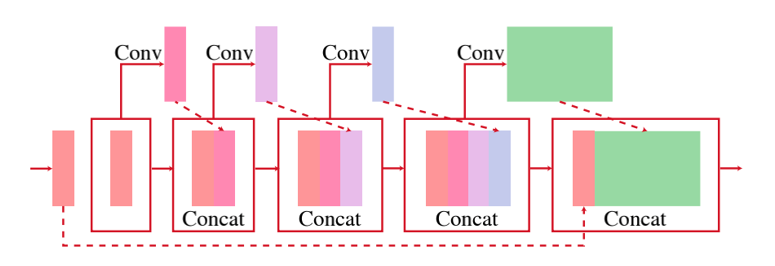

图5 局部时间模块

图6 时空模块结构

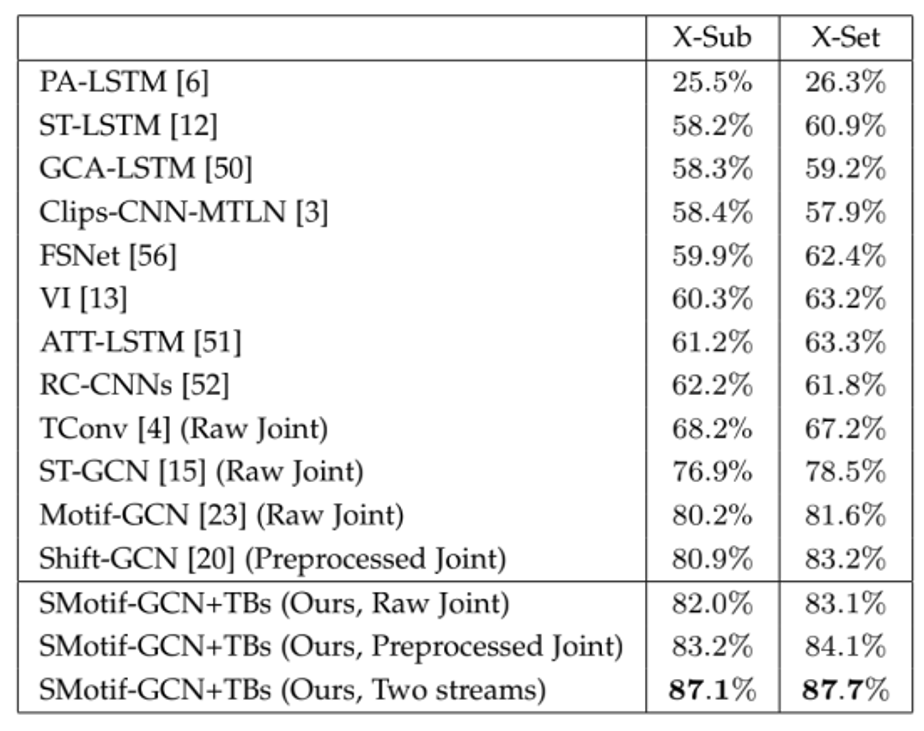

该方法目前已基于计图(Jittor)框架开源,代码由清华大学计算机系大三本科生雷长松实现。在相同batchsize下,Jittor的训练速度较Pytorch版本代码提升约50%,效果显著。

论文网页:

https://ieeexplore.ieee.org/document/9763364

代码开源:

https://github.com/wenyh1616/SAMotif-GCN/tree/jittor

点击下方的"阅读原文",可浏览IEEE T-PAMI的论文网页。

参考文献

Y-H Wen, L Gao, H Fu, F-L Zhang, S Xia, Y-J Liu, Motif-GCNs with local and non-local temporal blocks for skeleton-based action recognition, IEEE T-PAMI, 2022, doi: 10.1109/TPAMI.2022.3170511

Yan S, Xiong Y, Lin D, Spatial temporal graph convolutional networks for skeleton-based action recognition, AAAI, 2018, article No.: 912, 7444–7452.

Li M, Chen S, Chen X, et al. Actional-structural graph convolutional networks for skeleton-based action recognition, IEEE/CVF CVPR, 2019, 3595-3603.

Benson A R, Gleich D F, Leskovec J, Higher-order organization of complex networks, Science, 2016, Vol. 353, No. 6295, 163-166.

Fang Y, Lin W, Zheng V W, et al. Semantic proximity search on graphs with metagraph-based learning, IEEE ICDE, 2016, 277-288.

Liu J, Shahroudy A, Perez M, et al. Ntu rgb+ d 120: A large-scale benchmark for 3d human activity understanding, IEEE T-PAMI, 2019, Vol. 42, No. 10, 2684-2701.

GGC往期回顾

1. Scopus发布2021年度影响因子, CVMJ从4.0升至5.9

您可通过下方二维码,关注清华大学计算机系图形学实验室,了解计算机图形学、Jittor框架、CVMJ期刊及会议的相关资讯。