计图开源:高林团队CVPR发文, 提出基于NeRF的场景风格化方法

图1 StylizedNeRF的风格化效果

理想的3D场景新视角风格化技术应该能够提供稳定且3D视角一致的风格化效果。具体而言,在不同视角下的同一物体应该具备一致的风格化外观,同时风格效果要接近用户输入的风格图片。现有的3D风格化技术难以同时满足以上要求。

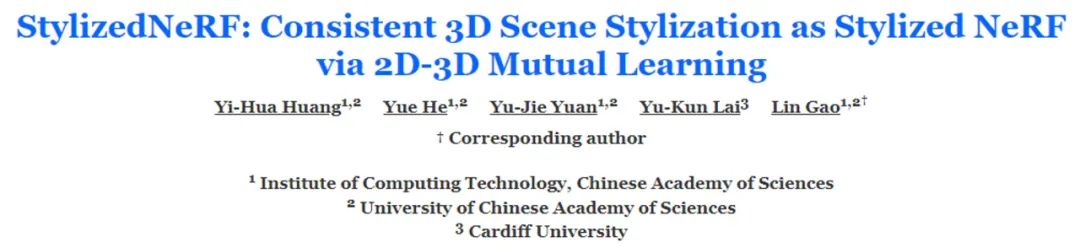

图2 神经辐射场和2D风格化方法的优势结合

StylizedNeRF核心在于一种新颖的2D到3D的互学习技术,来训练一个具备风格化能力的神经辐射场。如图3所示,2D的风格化方法采用的是经典的AdaIN[4]。其中的2D卷积解码器Decoder和添加了风格颜色预测模块的神经辐射场StylizedNeRF之间进行2D-3D互学习。

互学习的首个阶段是将神经辐射场的几何先验传递给2D风格化卷积网络,同时训练2D网络的风格化能力。在此阶段,风格化损失和内容损失在2D卷积解码器的输出上进行计算和优化。由于2D卷积解码器相比于神经辐射场并不占用太大的显存空间,因此可以使用更大的采样图块,获得更高质量的风格化结果以指导StylizedNeRF。

图4 条件控制风格化的结果

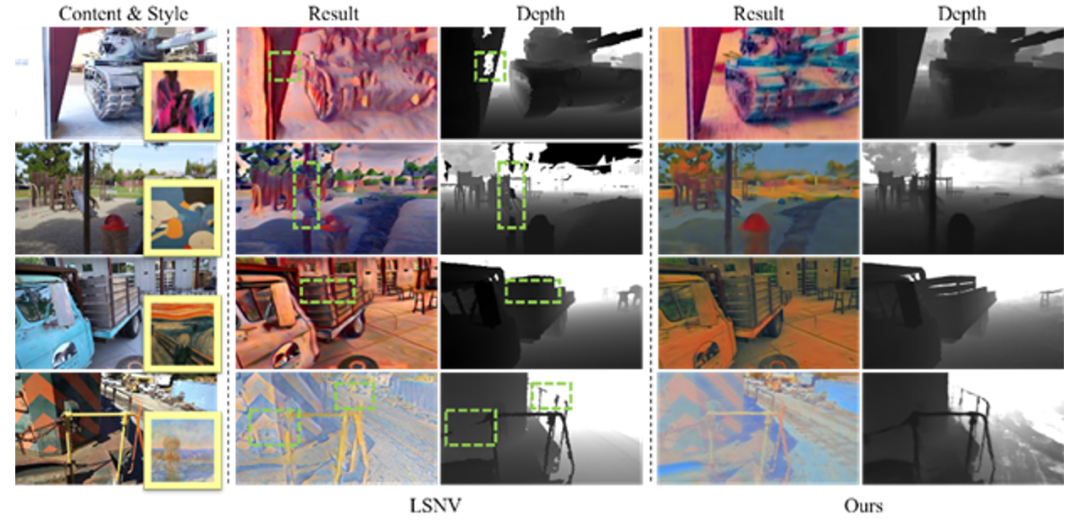

图5与方法LSNV [2]的对比

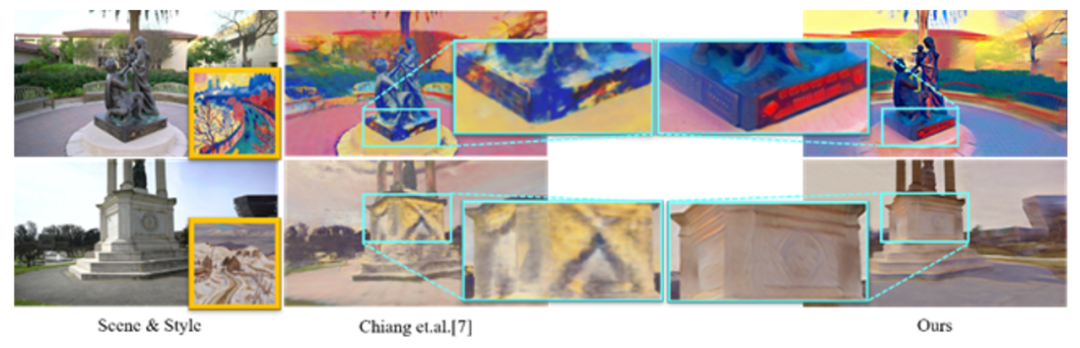

下图展示了StylizedNeRF与最新的发表在WACV2022上的同期工作[3]的比较结果。可以看出,由于[3]的风格化损失和内容损失是在一个近似大图块的小采样图块上计算得到的,因此会丢失一些局部的细节。基于2D-3D互学习机制,StylizedNeRF能够更好地利用2D方法给出的精细指导,从而更好地保持了风格化之后的细节信息。

StylizedNeRF通过一种2D-3D的互学习方法,让神经辐射场网络和2D的卷积解码网络相互利用对方的优势,达到了兼具一致性和高质量风格化的效果。

该论文已发表在计算机视觉顶级会议CCF A类会议IEEE/CVF CVPR上。有关论文的更多细节及论文、代码的下载,请浏览项目主页。

该研究论文的作者还包括高林团队的研究生黄熠华、何月和袁宇杰以及英国卡迪夫大学的来煜坤教授。

Yi-Hua Huang, Yue He, Yu-Jie Yuan, Yu-Kun Lai and Lin Gao, StylizedNeRF: Consistent 3D Scene Stylization as Stylized NeRF via 2D-3D Mutual Learning, IEEE/CVF CVPR, 2022. Hsin-Ping Huang,Hung-Yu Tseng, Saurabh Saini, Maneesh Singh, and Ming-Hsuan Yang, Learning to stylize novel views, IEEE/CVF CVPR, 2021, 13869-13878.

Pei-Ze Chiang,Meng-Shiun Tsai, Hung-Yu Tseng, Wei-Sheng Lai, and Wei-Chen Chiu, Stylizing 3D Scene via Implicit Representation and HyperNetwork, IEEE/CVF Winter Conference on Applications of Computer Vision, 2022,1475-1484.

Xun Huang andSerge Belongie, Arbitrary style transfer in real-time with adaptive instance normalization, IEEE/CVF ICCV, 2017, 1501-1510.

GGC往期回顾

您可通过下方二维码,关注清华大学计算机系图形学实验室,了解计算机图形学、Jittor框架、CVMJ期刊及会议的相关资讯。