生成对抗网络(GANs)是现今很流行的一种图像生成方法,但传统的生成对抗网络会面临模式坍塌和非结构化隐式空间的问题。近期,浙江大学的邵天甲团队于ICCV 2021发表了一项重要成果,提出了一种无监督的图像生成学习方法MICGANs (Mixtureof Infinite Conditional GANs)。给定一个包含多种类别图像的数据集,MICGANs可以从“无限”的生成对抗网络出发,预测出较为正确的聚类结果,从而帮助解决模式坍塌问题提高生成质量。在训练完成之后,MICGANs可以根据得到的类别进行有条件的生成。以往的一些无监督方法(如ClusterGAN)往往需要类别数量的监督信息,而MICGANs不需要这些信息,是一种完全无监督的方法。该方法已开源了基于计图实现的代码,网络模型的训练速度较Pytorch提升10%。Part 1

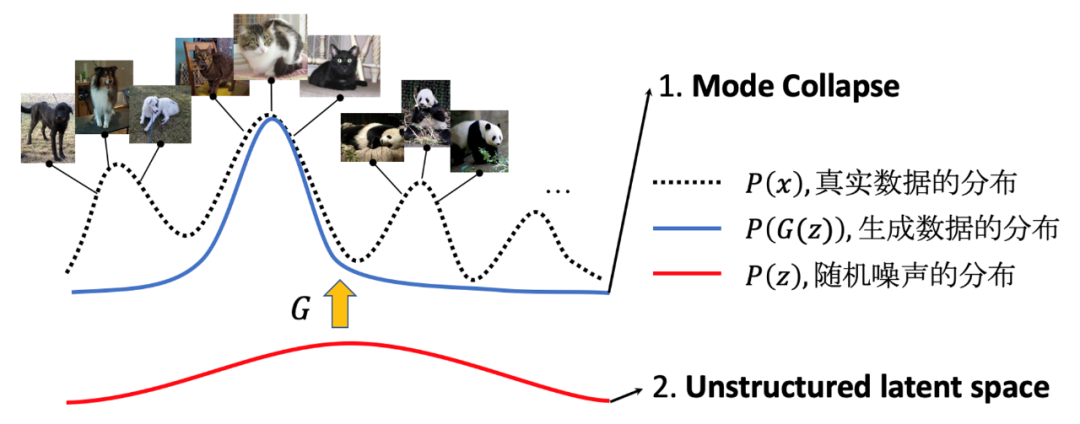

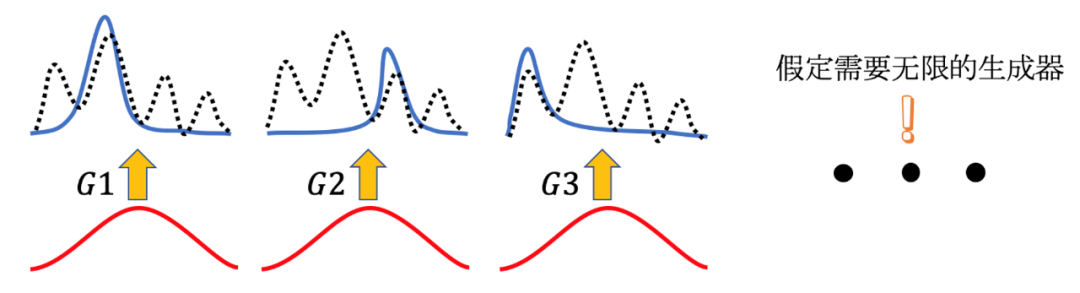

生成对抗网络(GANs)是现今很流行的一种图像生成方法。生成对抗网络的目标是希望训练一个生成模型使得它能将够将随机信号映射到生成图像上,并且这个生成图像的分布与真实图像的分布一致。而通常的生成对抗网络往往会面临模式坍塌和非结构化隐式空间的问题,如图1所示。模式坍塌指的是生成器只能够生成一些主要类别中的图像而忽视了其他类别,比如说,给定包含多种动物的数据集而生成器却只能生成猫的图像。而非结构化隐式空间会使得生成结果无法控制,比如在上面的例子中,非结构化隐式空间会使得我们无法控制生成哪种动物的图像。因而,作者提出了一种新的想法,即利用mode collapse本身来避免这些问题。简单来说,作者希望用一个生成器来映射一个类别,用足够多的生成器来映射所有类别。而这整个过程是无监督的,即模式的数量等先验信息都没有给定。为了解决生成器的数量的问题,作者假定了需要无限数量生成器(如图2)。图2 无限数量的生成器

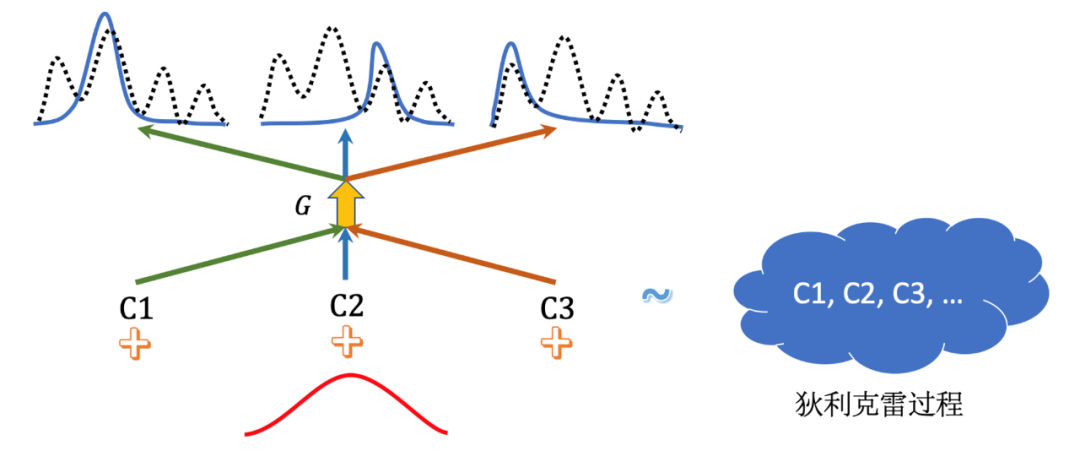

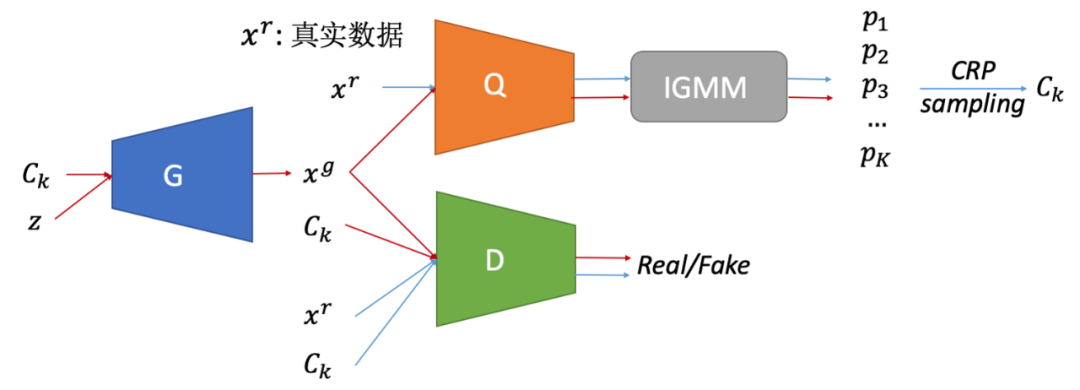

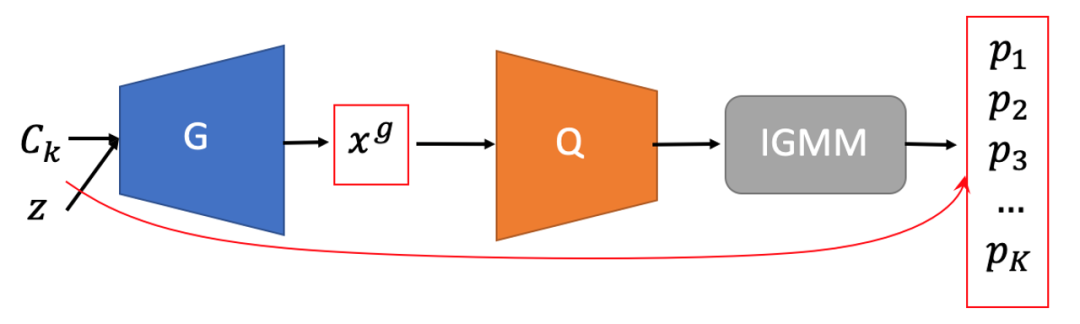

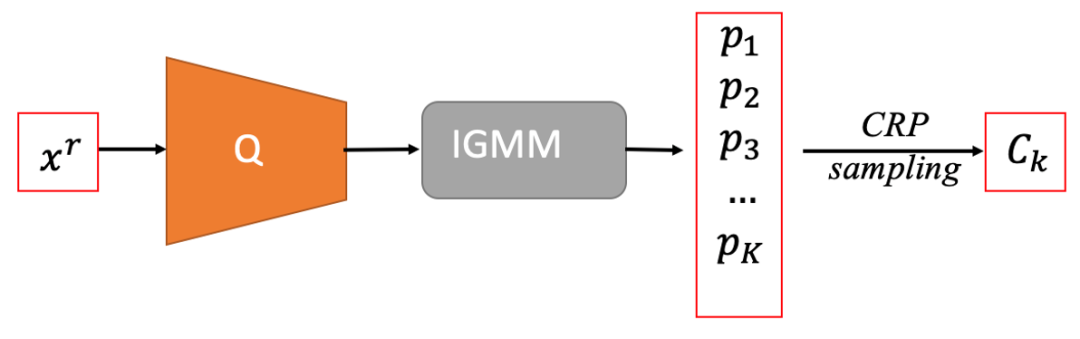

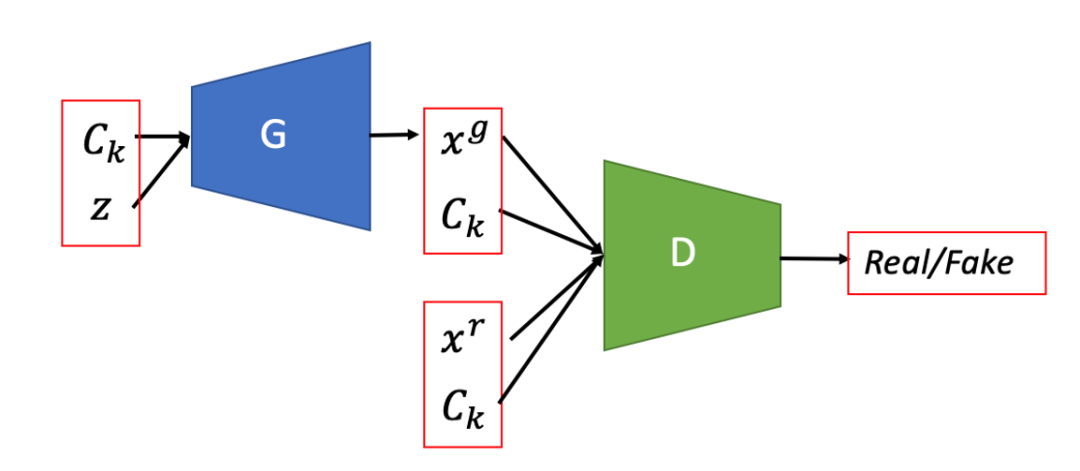

而为了更高效的训练,作者用条件对抗网络来建立映射关系。无限对抗生成网络用无限的条件数量来代替。同时,作者用狄利克雷过程(DirichletProcess)来对这些条件的先验分布建模,如图3所示。MICGANs的训练是在聚类和生成训练中迭代进行的,作者将其称为对抗式的中餐馆过程ACRP (Adversarial Chinese Retaurant Process)。中餐馆过程CRP(Chinese Retaurant Process)是狄利克雷过程的等价表达,具有“富者越富”的性质。在这篇工作中,作者希望通过中餐馆过程来实现“已被采样到过多次的类别更容易再次被采样到”的效果。MICGANs的网络的整体结构如图4所示。其中,生成器G用于生成生成图像,判别器D用于区分真实图像与生成图像,编码器Q以及无限高斯混合模型IGMM(Infinite Gaussian Mixture Model)用于对图像的分类。同时,在实际的ACRP训练时,MICGANs需要被给定一个足够大的K值来近似“无限”的条件数量。

图4 MICGANs整体网络框架

在实际训练时,每次循环迭代大致分为三个步骤。

步骤一:使用生成的数据来训练编码器Q。将生成图像输入编码器Q和IGMM之后可以获得该图像在K个类别上的概率,并以生成网络的输入条件作为监督信息来训练编码器Q。步骤二:对真实数据进行聚类并调整IGMM。将真实图像输入编码器Q和IGMM之后可以获得该图像在K个类别上的概率,运用CRP采样获取真实数据的伪标签。然后根据图像的编码和分类结果调整IGMM的分布参数。

步骤三:在获得真实数据的伪标签之后,就可以将其用于训练条件生成对抗网络。

图7 ACRP训练步骤三

需要注意的是,在进行ACRP训练之前,需要对生成网络和对抗网络进行初始化训练,使得生成网络能够生成一定质量的图像。

Part 3

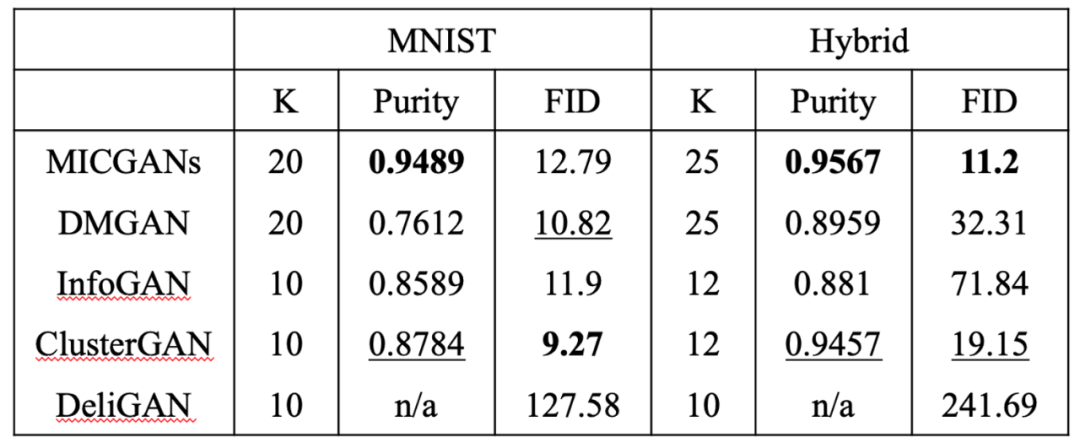

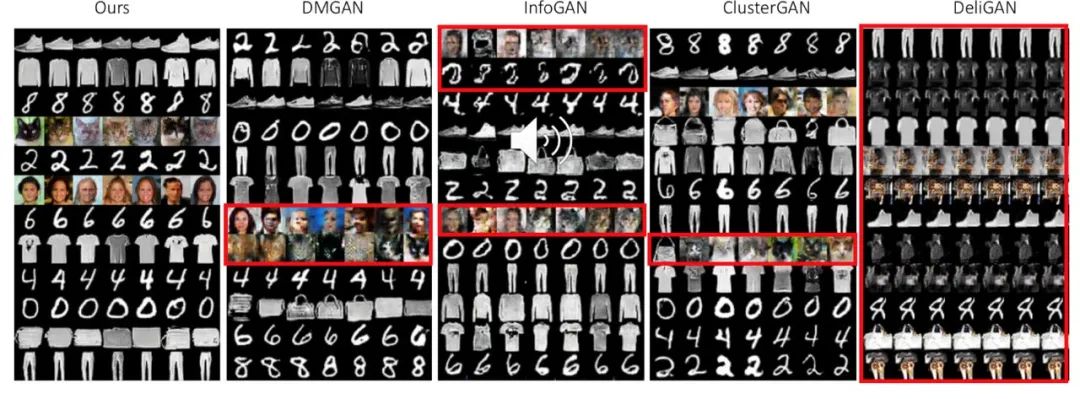

下表展示了在MNIST数据集和Hybrid数据集上MICGANs和其他方法的生成结果对比。其中Hybrid数据集是作者制作的混合了MNIST, FashionMNIST, 猫和人脸的图像的数据集。下表中的Purity代表了聚类的准确度,FID代表了生成图像的质量。从表格中我们可以看出MICGANs在多数情况下具备更好的聚类能力和生成能力。值得注意的是,InfoGAN,ClusterGAN和DeliGAN需要类别数量的先验信息。

表1 与现有的方法的对比结果

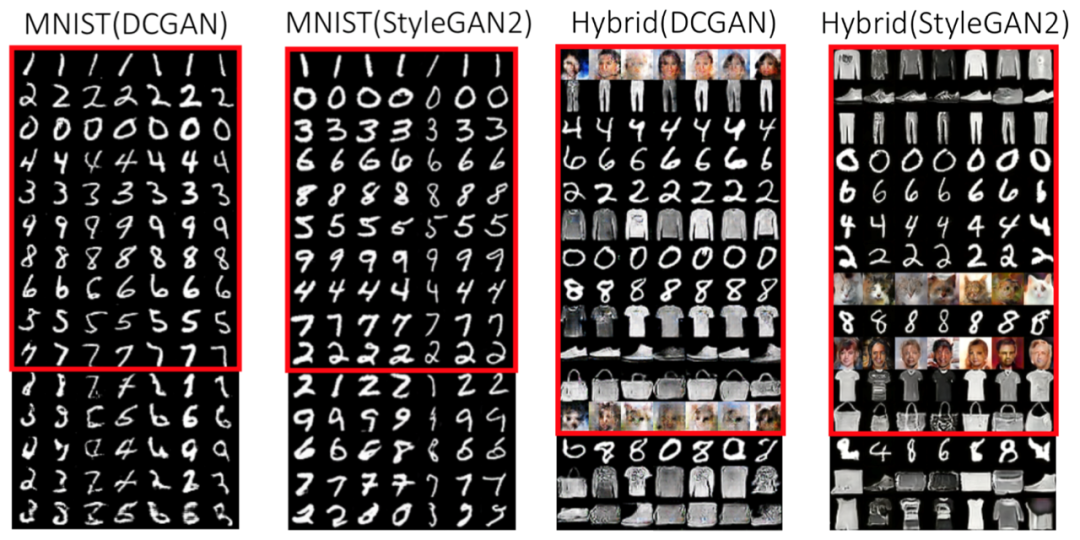

图8展示了MICGANs在MNIST和Hybrid数据集上的生成结果。由于该框架是一个通用的框架,所以作者在DCGAN和StyleGAN2上都进行了测试。图中,每一行代表一个生成类别,并且这些行都按照类别的权重进行了排序。可以看出,在MNIST中,前十行就覆盖了0-9所有的数字。而在Hybrid数据集中,MICGANs也可以清晰地辨别出所有类别。图8 MNIST和Hybrid数据集的生成结果

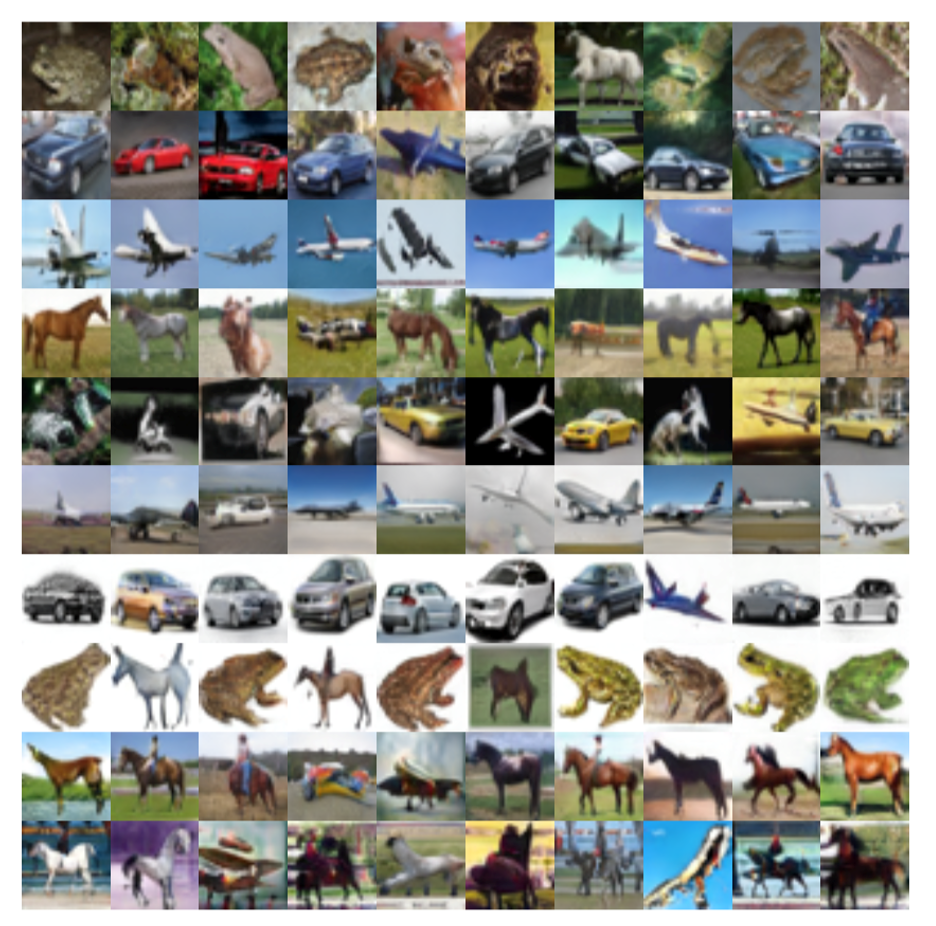

图9展示的是MICGANs在CIFAR数据集上的结果。可以发现有些行的生成图像包含了两个或者多个真实图像的类别。作者认为这是由于无监督网络对图像的分类依据可能与人类的标签不同。图9 CIFAR数据集上的生成结果

图10展示了MICGANs与现有方法在生成结果上的可视对比。可以看出,MICGANs的生成质量更高,并且分类更加清晰。

该论文的作者还包括浙江大学的应辉博士、周昆教授,利兹大学的王鹤教授和克莱姆森大学的杨垠教授。该研究项目已发布基于计图实现的代码,链接为

https://github.com/yinghdb/MICGANs-jittor。在计图框架的加持下,MICGANs在ACRP训练阶段的速度相较于Pytorch具有10%的提升。Hui Ying, He Wang, Tianjia Shao, Yin Yang and Kun Zhou, Unsupervised Image Generation with Infinite Generative Adversarial Networks, Proceedings of the IEEE/CVF International Conference on Computer Vision, 14284--14293, 2021.

GGC往期回顾

您可通过下方二维码,关注清华大学图形学实验室,了解图形学、Jittor框架、CVMJ期刊和CVM会议的相关资讯。