计图开源:基于标准化生成流的人体运动风格迁移方法

热列庆祝中国奥运代表团勇获38枚金牌32枚银牌和18枚铜牌!

近期,清华大学温玉辉博士后、刘永进教授、中科院计算所副研究员高林、香港城市大学傅红波教授等合作,在CVPR2021上发表论文,提出了一种基于标准化生成流(Glow)的自回归运动风格迁移方法,并在GitHub上开源了Jittor代码。

Part1

图1 运动风格迁移:正常地跑步 -> 沮丧地跑步

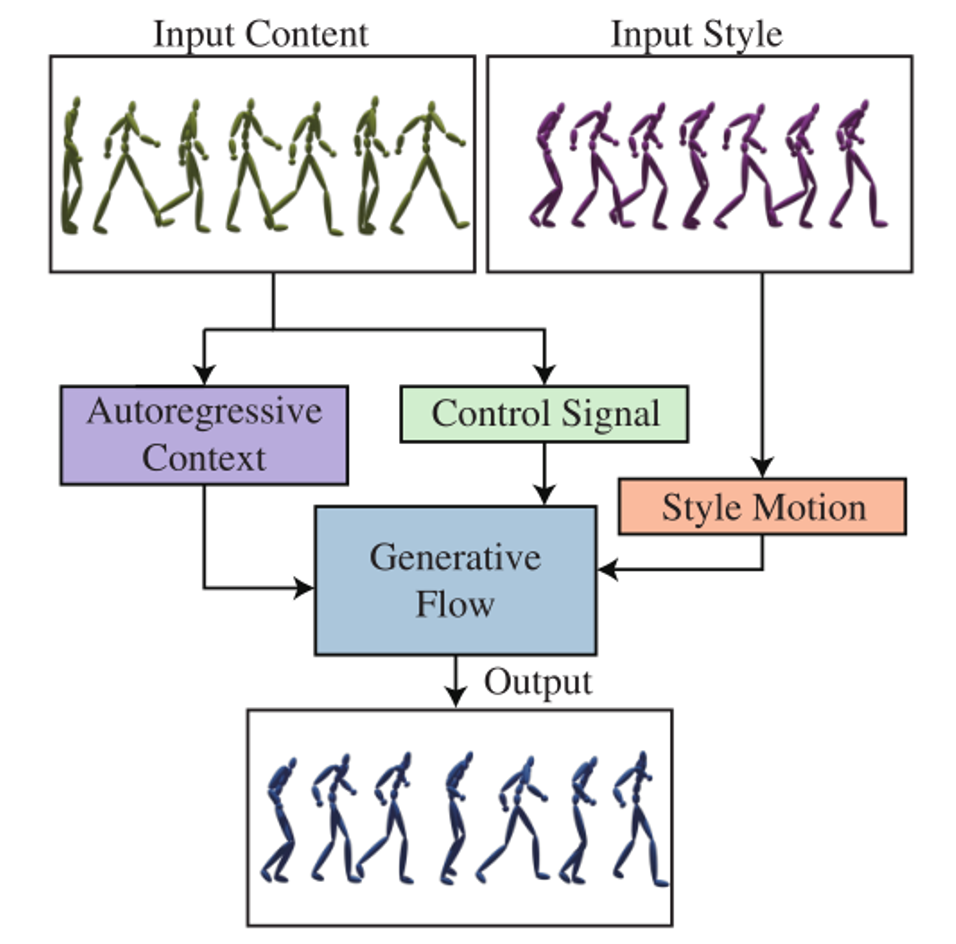

为了解决这些问题,清华大学、中科院计算所和香港城市大学的研究人员联合提出了一种基于标准化生成流(Glow)的自回归运动风格迁移方法,该工作已入选计算机视觉领域顶会CVPR 2021[3]。

Part2

Glow的核心思想是,通过一组连续的可逆变换,将复杂的数据分布,映射到简单的标准高斯分布,从而学习复杂样本的概率分布。

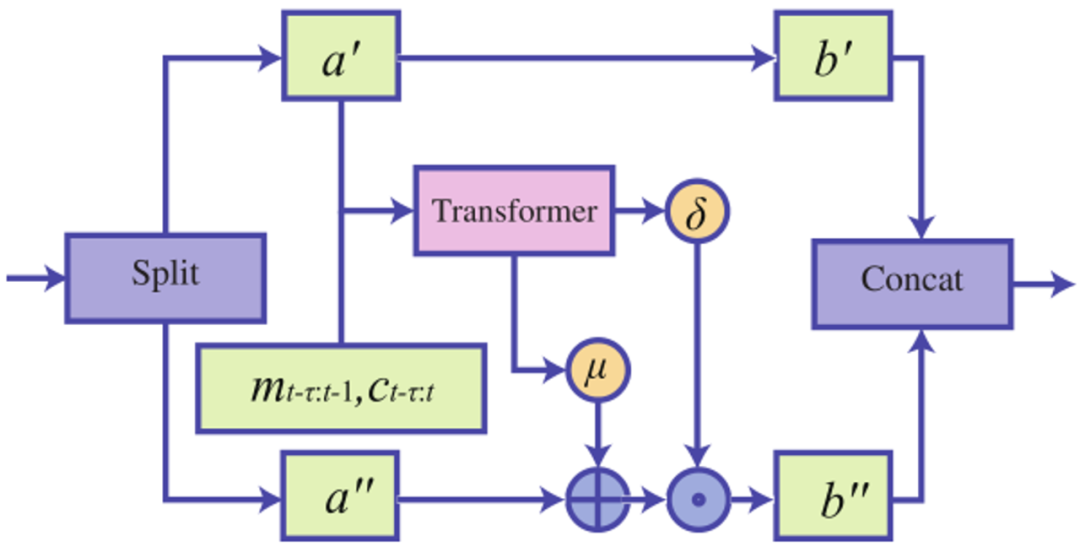

在仿射耦合变换中,如图4,作者引入了自回归编码结构,并且使用Transformer自回归编码结构,关注运动序列的全局信息,解决了LSTM自回归编码结构的误差累积问题。

图4 标准化生成流的单层流结构

Part3

结果展示

该方法解决了LSTM自回归编码结构的误差累积问题(如图5所示)。为了验证本方法的泛化能力,作者使用不包含“strutting”风格标签的数据进行训练,并在包含“strutting”风格标签的数据上测试。

图7 对比结果展示

Part4

Jittor开源

https://github.com/IGLICT/Stylemotion

Jittor是清华大学计算机图形学实验室开源的自主深度学习框架。在相同batchsize下,Jittor的训练速度较Pytorch版本代码提升了150%左右,推理速度较Pytorch版本提升了200%,效果显著。

更多的原理和算法细节,请参考以下视频:

图8 人体运动风格迁移方法的原理和演示

Kfir Aberman,Yijia Weng, Dani Lischinski, Daniel Cohen-Or, and Baoquan Chen. Unpaired MotionStyle Transfer from Video to Animation,ACM Transactions on Graphics, 2020, Vol. 39, No. 4, Article No. 64.

Daniel Holden, Jun Saito, and Taku Komura. A Deep Learning Framework for CharacterMotion Synthesis and Editing, Transactions on Graphics, 2016, Vol. 35, No. 4, Article No. 138.

Yu-Hui Wen#, Zhipeng Yang#, Hongbo Fu, LinGao*, Yanan Sun, and Yong-Jin Liu*, Autoregressive Stylized Motion Synthesis with Generative Flow, Proceedings of the IEEE/CVFConference on Computer Vision and Pattern Recognition (CVPR), 2021, 3612–13621.

温玉辉博士(共同一作),清华大学博士后(合作导师:刘永进教授),主要研究方向为计算机视觉、人工智能、人体运动分析。2020年于中科院计算所获博士学位。相关的研究成果发表在计算机视觉和人工智能领域的CVPR、AAAI会议和人体运动步态分析专业刊物Gait&Posture等上,曾获得博士生国家奖学金、中科院计算所所长特别奖等荣誉。

该论文的作者还包括香港城市大学的傅红波教授、中科院计算所的高林副研究员、清华大学孙亚男硕士生和刘永进教授。论文通讯作者为高林和刘永进。

您可通过下方二维码,关注清华大学图形学实验室,了解图形学、Jittor框架、CVMJ期刊和CVM会议的相关资讯。